Đã kiểm duyệt nội dung

Bạn muốn chỉ cho Google biết nên và không nên "ghé thăm" khu vực nào trên website của mình? Đó chính là lúc bạn cần câu trả lời cho câu hỏi robots txt là gì?. Về cơ bản, đây là một tệp tin hoạt động như "người gác cổng" thông minh, giúp bạn điều hướng các bot tìm kiếm, bảo vệ những dữ liệu không cần công khai và tối ưu hóa hiệu suất website. Tại TLT, chúng tôi nhận thấy nhiều doanh nghiệp chưa tận dụng hết công cụ này. Do đó, bài viết sẽ là cẩm nang chi tiết, không chỉ làm rõ robots txt là gì mà còn hướng dẫn bạn cách cấu hình chuẩn nhất để cải thiện thứ hạng SEO.

Robots txt là gì và vì sao tệp nhỏ này lại “định hình” cách công cụ tìm kiếm nhìn vào website của bạn? Về bản chất, robots.txt là một tệp văn bản đặt ở thư mục gốc của website dùng để chỉ dẫn trình thu thập dữ liệu (bots) phần được phép và không được phép thu thập. Nó là một phần của Robots Exclusion Protocol (REP). Dù robots.txt không trực tiếp tăng thứ hạng, nó điều phối cách bot tiêu thụ tài nguyên và quyết định những vùng nào đáng crawl — từ đó tác động mạnh đến tốc độ index, tính toàn vẹn nội dung, và trải nghiệm tìm kiếm.

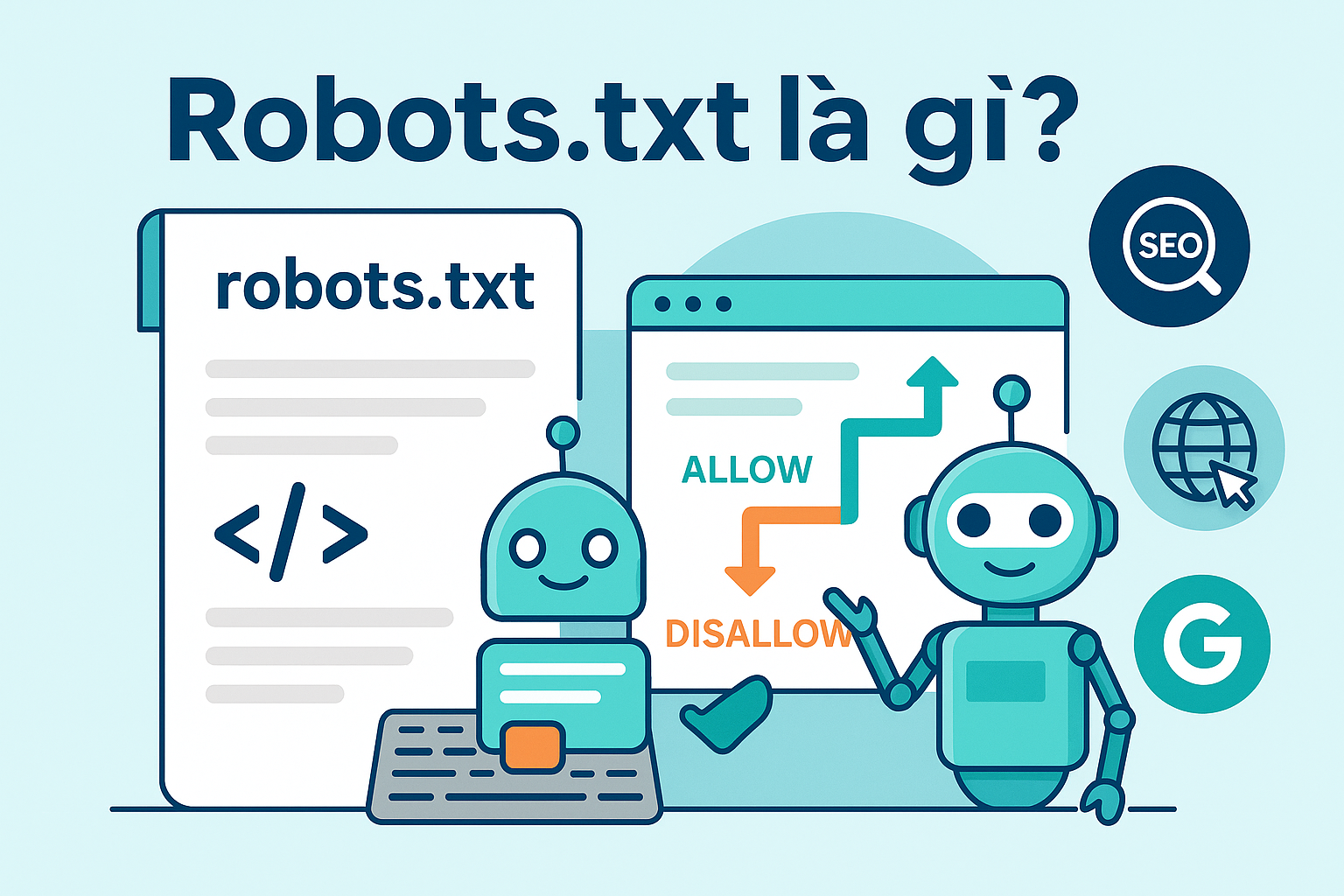

Crawl budget (ngân sách crawl) là “số lần” và “tần suất” bot sẵn sàng truy cập website bạn trong một khung thời gian. Trên site lớn, nếu bot lãng phí thời gian ở khu vực không mang giá trị SEO (kết quả tìm kiếm nội bộ, trang lọc vô tận, thư mục tạm), phần nội dung sinh giá trị (bài viết, danh mục, sản phẩm) sẽ bị crawl thưa hơn. Dùng robots.txt chặn khu vực “nhiễu” giúp:

Robots.txt không phải công cụ bảo mật, nhưng là “điểm gợi ý” để bot tránh khu vực nhạy cảm như /admin/, /config/, /checkout-test/. Với con người hoặc bot độc hại, bạn vẫn cần auth, firewall, và rule server. Tuy nhiên, với bot “tử tế” (Googlebot/ Bingbot), robots.txt giúp không lộ đường dẫn nhạy cảm trên SERP (dù URL vẫn có thể xuất hiện nếu có nhiều link trỏ vào — xem thêm phần “Giới hạn & hiểu lầm”).

Khai báo dòng Sitemap: trong robots.txt như một “biển chỉ đường” để bot nhanh tìm tới sitemap XML. Hệ quả: bot hiểu cấu trúc thông tin, khám phá URL mới hiệu quả và bám sát cập nhật nội dung.

Robots.txt là tệp dạng cặp quy tắc theo từng User-agent (đại diện loại bot). Một khối quy tắc cơ bản:

User-agent: *

Disallow: /admin/

Allow: /blog/

Sitemap: https://example.com/sitemap.xml

$ là neo cuối chuỗi (end-of-string). Ví dụ, chặn toàn bộ PDF:

User-agent: *

Disallow: /*.pdf$

User-agent: *

Disallow: /wp-admin/

Disallow: /search/

Disallow: /tag/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://tlt.vn/sitemap.xml

Lý do: /search/ và /tag/ có thể gây trùng lặp nội dung hoặc tạo vô hạn biến thể.

User-agent: *

Disallow: /*?sort=

Disallow: /*?filter=

Disallow: /cart/

Disallow: /checkout/

Allow: /product/

Sitemap: https://example.com/sitemap.xml

Lý do: Faceted navigation dễ “nổ” URL. Chặn tham số phổ biến giúp tiết kiệm crawl.

User-agent: *

Allow: /images/

Disallow: /tmp/

Sitemap: https://example.com/image-sitemap.xml

Chặn nhầm có thể ảnh hưởng đánh giá trang đích quảng cáo. Nếu cần quy tắc riêng, thêm khối User-agent cụ thể và đừng Disallow chúng.

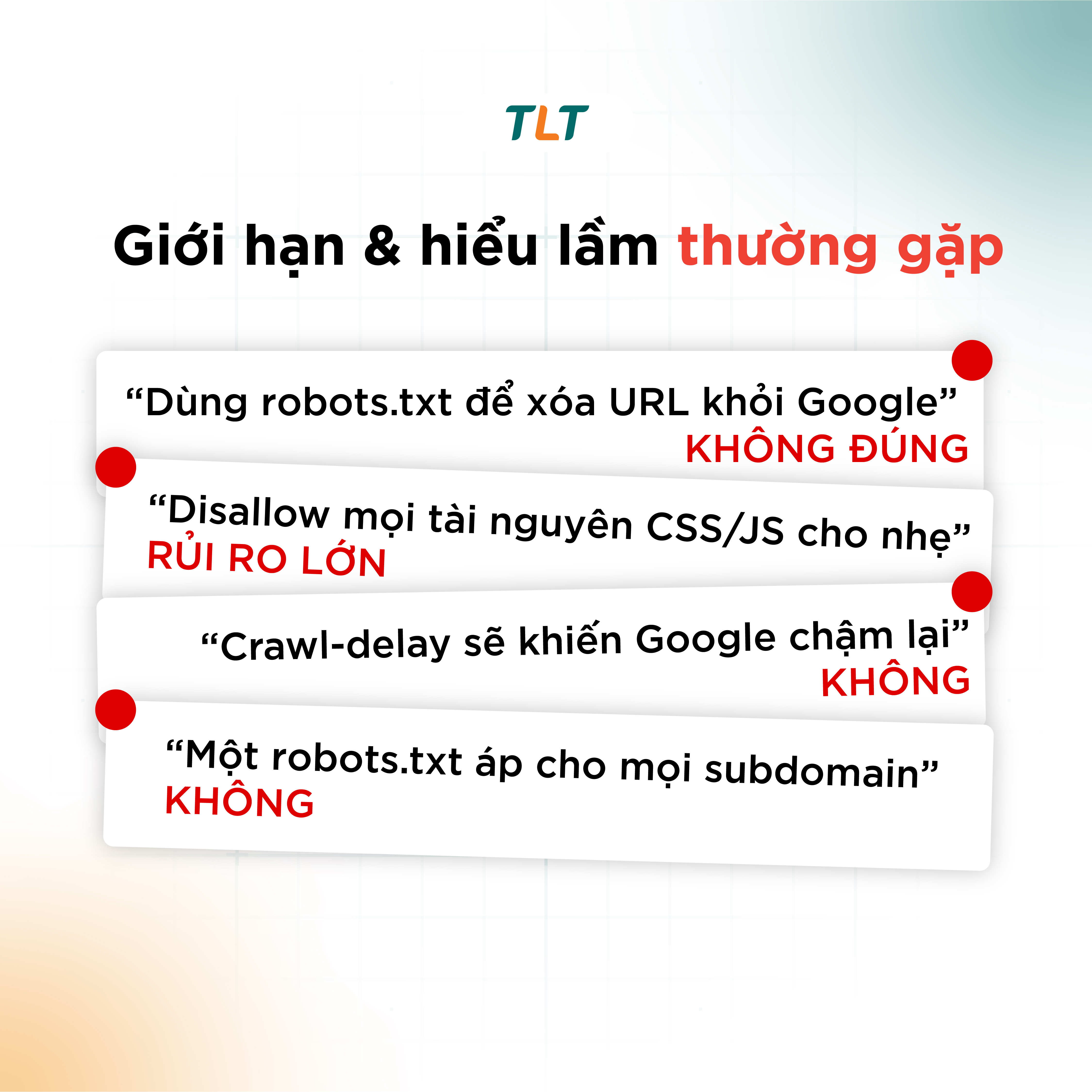

Robots.txt chỉ ngăn crawl, không bảo đảm ngăn index. Một URL có thể vẫn xuất hiện nếu bên ngoài có nhiều liên kết trỏ vào (dù Google không thu thập nội dung). Muốn loại khỏi chỉ mục:

Google cần render trang để hiểu nội dung/UX. Nếu chặn CSS/JS quan trọng, bot có thể đánh giá sai bố cục, che khuất nội dung, ảnh hưởng khả năng hiển thị. Chỉ chặn các tài nguyên thực sự không cần thiết, đừng chặn CSS/JS cốt lõi.

Google không hỗ trợ Crawl-delay. Nếu cần giảm tải, dùng server throttling, tối ưu cache/CDN, hoặc thay đổi cấu hình tốc độ crawl (nếu tính năng này khả dụng trong Search Console).

Mỗi subdomain cần tệp robots.txt riêng của nó.

User-agent: *

Disallow: /

Khắc phục: gỡ ngay dòng này, cho phép crawl; yêu cầu bot tái thu thập (không có nút magic nào, nhưng cập nhật sitemap & nội dung mới giúp bot quay lại nhanh hơn).

Khắc phục: mở crawl trang cần loại bỏ, thêm meta robots noindex, sau khi bot thấy thẻ và URL biến mất khỏi chỉ mục mới cân nhắc chặn lại nếu cần.

Khắc phục: bỏ chặn thư mục assets chính (ví dụ /static/, /assets/), chỉ chặn bản build tạm hoặc nguồn không cần render.

Ví dụ Disallow: /*? vô tình chặn mọi URL có tham số (kể cả UTM) → hỏng đo lường.

Khắc phục: chặn tham số đích danh gây trùng lặp: Disallow: /*?sort=.

Khắc phục: thêm robots.txt riêng cho từng host: https://m.example.com/robots.txt, https://blog.example.com/robots.txt.

1. Robots.txt có bắt buộc không?

Không, nhưng rất nên có để kiểm soát hành vi bot, đặc biệt với site lớn.

2. Đặt robots.txt ở đâu?

Thư mục gốc host: https://domain/robots.txt. Subdomain cần tệp riêng.

3. Google có hỗ trợ Crawl-delay không?

Không. Dùng server throttling/CDN hoặc tính năng giới hạn tốc độ crawl nếu Search Console cho phép.

4. Chặn sitemap trong robots.txt có được không?

Không có lý do hợp lệ để chặn. Ngược lại, hãy khai báo Sitemap: trong robots.txt.

5. Muốn ẩn một file PDF khỏi kết quả tìm kiếm thì làm gì?

Dùng X‑Robots‑Tag: noindex trong header HTTP của file PDF (và đừng chặn crawl PDF đó).

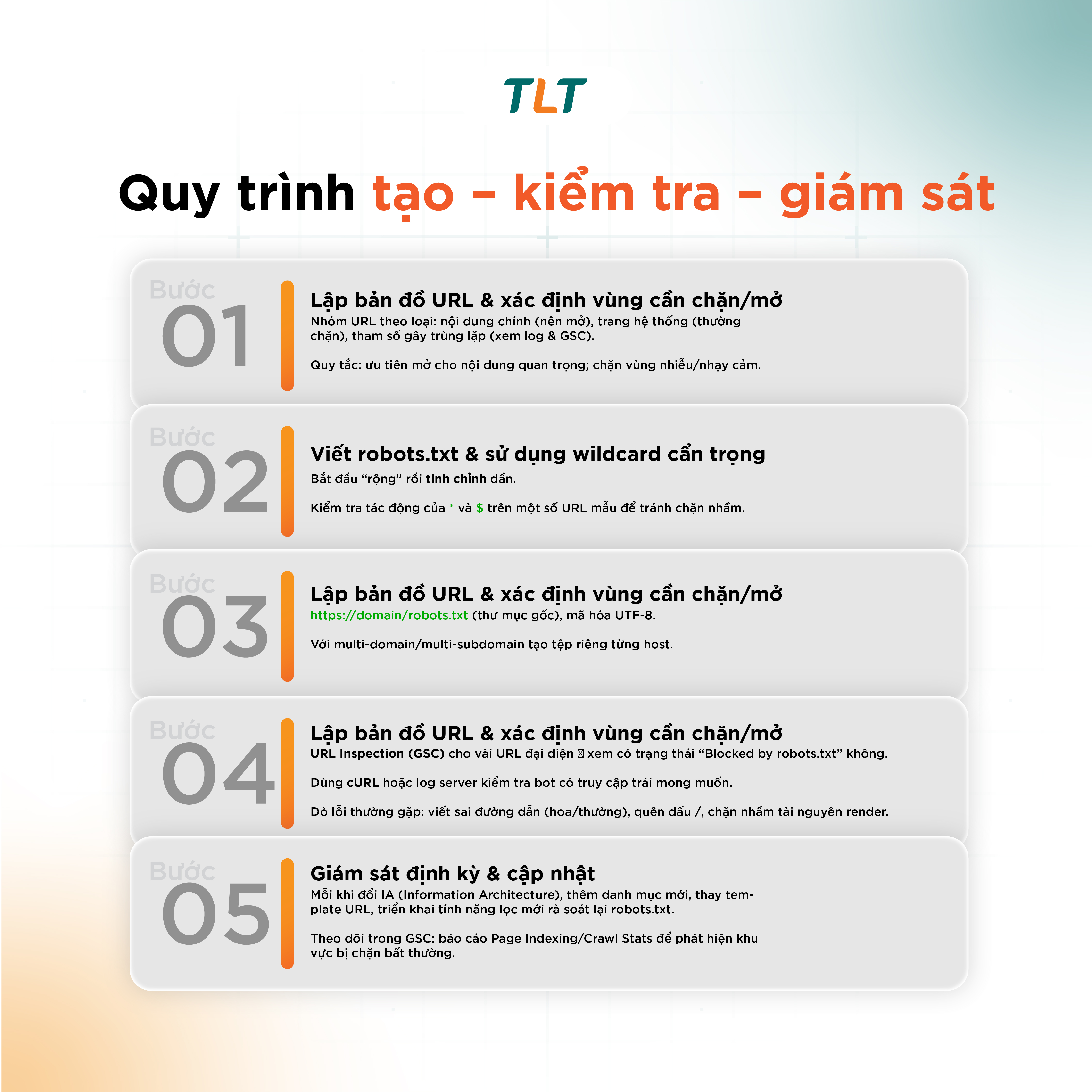

File robots.txt không phải là một tệp văn bản đơn giản mà là một công cụ chiến lược thiết yếu trong SEO kỹ thuật, đóng vai trò như một "người gác cổng" chỉ dẫn các công cụ tìm kiếm. Bằng cách điều phối ngân sách thu thập dữ liệu một cách thông minh, bảo vệ các khu vực không cần thiết khỏi bot, và chủ động dẫn lối chúng đến sitemap, bạn đang kiến tạo một con đường hiệu quả để Google khám phá những nội dung giá trị nhất. Tuy nhiên, sức mạnh này đòi hỏi sự chính xác tuyệt đối, bởi một sai lầm nhỏ trong cú pháp có thể dẫn đến những hậu quả nghiêm trọng. Để đảm bảo "người gác cổng" của bạn đang hoạt động một cách hoàn hảo và an toàn, hãy liên hệ với TLT ngay hôm nay để được tư vấn và triển khai chuyên nghiệp.

CÔNG TY TNHH TM & DV CÔNG NGHỆ TLT

Địa chỉ: 53 Ngô Bệ, Phường Tân Bình, Thành phố Hồ Chí Minh

Điện thoại: 0283.811.9797

Email: tlt@tltvietnam.vn

Website: https://tlt.vn/